Neue Version von Blickshift Analytics ist da!

Heute ist ein großer Tag für die Eye-Tracking-Community. Heute veröffentlichen wir die neue Version von Blickshift Analytics. Und mit ihr zwei neue fantastische Verbesserungen, die die tägliche Arbeit von Eye-Tracking-Forschern erheblich erleichtern werden. Die Analyse von Eyetracking-Daten wird dadurch viel schneller und genauer, und Sie Ihre Daten noch viel detaillierter analysieren bei gleichem oder sogar reduziertem Zeitaufwand

Werfen wir also einen Blick auf die zwei wichtigsten Highlights.

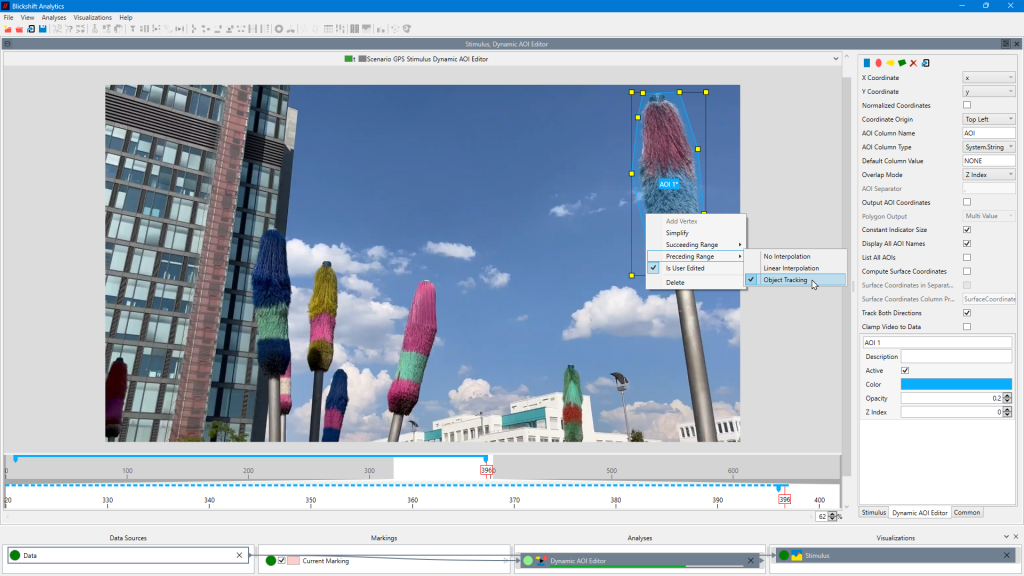

Dynamischer AOI-Editor mit Künstlicher Intelligenz

Völlig neuer dynamischer AOI-Editor mit Optionen zur Interpolation der AOI über die Zeit oder zur Nachverfolgung im Video.

Bis jetzt waren dynamische AOIs ein kompliziertes Thema in der Eye-Tracking-Analyse, insbesondere bei der Analyse von Daten von kopfgetragenen Eye-Trackern. Bis heute gibt es viele verschiedene Ansätze für den Umgang mit Areas of Interest. Aber alle Lösungen hatten Nachteile und führten zu Kompromissen. Schauen wir sie uns der Reihe nach genauer an bevor wir zum Schluss unsere Lösung damit vergleichen:

1.) Ein Standardverfahren bestand darin, das Experiment Fixation für Fixation durchzugehen und die Fixation einer AOI zuzuordnen. Dieser Ansatz war zwar genau, aber aufgrund der vielen manuellen Mausklicks sehr zeitaufwändig.

2.) Die Verwendung von Markern beschleunigte den Zuordnungsprozess, hatte aber den Nachteil, dass die Markerbilder im Blickfeld der Teilnehmer lagen, was zu Abweichungen in der visuellen Wahrnehmung führen konnte. Auch bei schwierigen Lichtverhältnissen, z. B. in Fahrsimulatoren, war diese Methode problematisch.

3.) Man konnte ein Bild eines Stimulus aufnehmen und einen Computer-Vision-Algorithmus die Fixation auf dem Stimulus aus der Perspektive des Teilnehmers abbilden lassen. In dynamischen Szenen kann dieser Ansatz nicht verwendet werden.

4.) Schließlich könnten Sie Ihre eigene Computer-Vision-Lösung entwickeln. Allerdings ist nicht jeder ein Experte für CV und die Implementierung des Codes ist sehr zeitaufwändig.

Es gab also keine perfekte Lösung. Und das war für uns unbefriedigend. Da es zu unserer Mission gehört, der Eye-Tracking-Community die perfekte Lösung zu bieten, haben wir uns überlegt, wie wir die Situation wirklich ändern können. Bereits im Sommer 2018 haben wir mit unseren ersten Forschungen im Bereich der dynamischen AOIs begonnen. Leider waren die Algorithmen, die wir verwenden wollten, zu diesem Zeitpunkt noch nicht leistungsfähig genug. Am Ende haben wir fünf Jahre gebraucht, um die beste Lösung für Sie zu entwickeln. Und, ja, die Ergebnisse sind überwältigend! Überzeugen Sie sich selbst mit dieser kurzen Demo auf unserem YouTube Kanal.

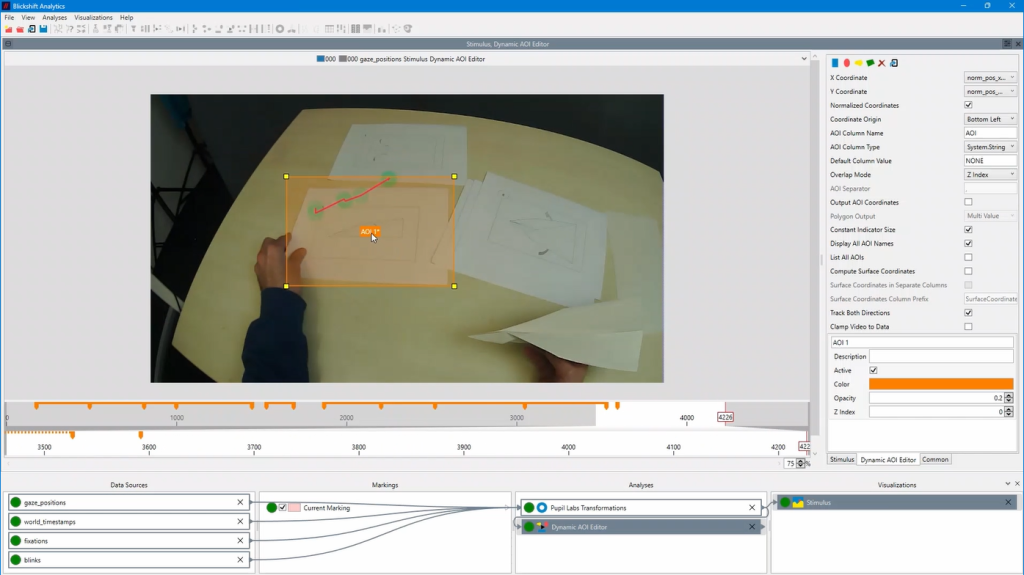

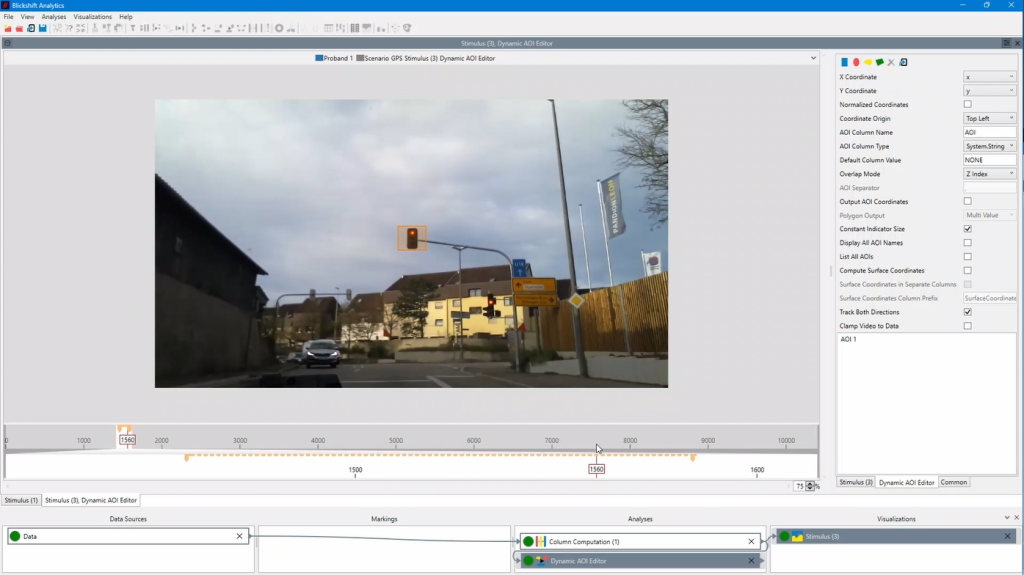

Unser dynamischer AOI-Editor überwindet alle oben genannten Nachteile und ist eine der faszinierendsten Komponenten, die wir je in unserem Entwicklungslabor erfunden haben!

Er funktioniert in vielen verschiedenen Szenarien. Von klassischen Desktop-Setups mit Videos, Webseiten, PC-Programmen oder Konsolenspielen als Stimuli, über Indoor-Aufnahmen wie in einem Labor, bis hin zu Outdoor-Experimenten wie in sonniger Umgebung, im Wald oder im Auto. Da auch schwierige Lichtszenarien auf unserer Anforderungsliste standen, können wir Ihnen nun auch hierfür eine Lösung anbieten. Darüber hinaus können auch VR- und AR-Setups von der Computer-Vision-basierten AOI-Erkennung profitieren, zum Beispiel wenn kein Zugriff auf das 3D-Modell besteht. Unsere Erfahrungen während des langen Betatests haben gezeigt, dass Sie die Zeit für die Datenaufbereitung deutlich reduzieren und Analyse-Setups erstellen können, die vorher überhaupt nicht möglich waren.

Dynamische AOIs in einem Usability Experiment mit einem am Kopf getragenen Eye-Tracker

Dynamische AOIs in einem Automotive Experiment mit einem festen Eye-Tracking-System

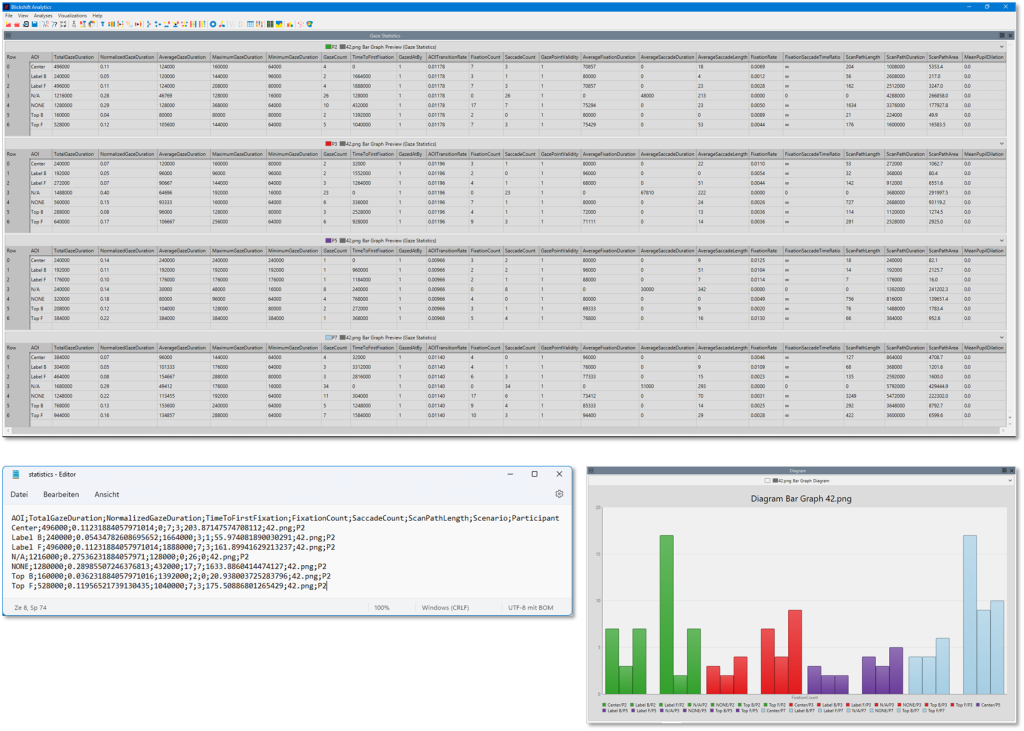

Unsere neue Statistikkomponente

Der neue Knoten Gaze Statistics enthält mehr als 20 zusätzliche Statistiken für Fixationen, Sakkaden, Scanpfade und Pupillenerweiterung, abhängig von den vorhandenen Basisdaten.

Abschließend möchten wir noch ein paar Worte über die neue Statistikkomponente verlieren. Bisher mussten Forscher, die sich mit Eye Tracking befassen, entweder bestehende R- oder Python-Skripte verwenden und sich auf die Qualität des Codes verlassen oder einen eigenen Arbeitsablauf entwickeln, um mit Hilfe von Tools wie R, anderer Statistiksoftware oder sogar Tabellenkalkulationsprogrammen Eye Tracking-Metriken zu erhalten. Das alles gehört der Vergangenheit an. Mit unserer neuen Statistikkomponente können Sie mit Blickshift bis zu 20 Standard-Eye-Tracking-Metriken sofort berechnen lassen. Nach der Berechnung können Sie die Ergebnisse entweder direkt in unserer Software mit einem Diagramm visualisieren oder die Metriken als CSV-Daten für Ihre spätere Analyse und Präsentation exportieren.

Blickbewegungsanalyse ohne Grenzen

Allein durch die Kombination dieser beiden Komponenten hebt Blickshift Analytics Ihre Eye-Tracking-Analyse auf eine ganz neue Ebene. Sie wird Ihre tägliche Arbeit produktiver und schneller machen, und vor allem werden Sie in der Lage sein, in der gleichen oder sogar in kürzerer Zeit als heute viel mehr Einblicke in das Blickverhalten Ihrer Teilnehmer zu gewinnen.

Wenn wir also Ihr Interesse geweckt haben, klicken Sie auf die Schaltfläche „Get Your Trial“ und erleben Sie das Gefühl von Eye-Tracking-Analyse ohne Grenzen!